AnythingLLM mit lokalem DeepSeek-LLM nutzen

In diesem Beitrag erfahren Sie, wie Sie AnythingLLM installieren und das Open-Source-KI-Modell DeepSeek lokal auf Ihrem Rechner einbinden können. Diese Lösung bietet maximale Privatsphäre, da keine Cloud-API genutzt wird.

Was ist AnythingLLM?

AnythingLLM ist eine Plattform, die Ihnen erlaubt, verschiedene Large Language Models (LLMs) zu verwenden, um Texte zu analysieren, Fragen zu beantworten oder Dokumente zu verarbeiten. Die Software kann lokal betrieben werden, wodurch Ihre Daten auf Ihrem Rechner bleiben.

Was ist DeepSeek?

DeepSeek ist ein Open-Source-LLM, das leistungsfähige natürliche Sprachverarbeitung ermöglicht. Es kann vollständig lokal betrieben werden, sodass keine Daten an externe Server gesendet werden.

Installation von AnythingLLM mit lokalem DeepSeek

Voraussetzungen

Stellen Sie sicher, dass folgende Komponenten auf Ihrem System installiert sind:

- Python (>=3.9)

- Git

- Docker (empfohlen für eine einfache Installation)

- CUDA (falls GPU-Unterstützung gewünscht ist)

Schritt 1: AnythingLLM installieren

- Öffnen Sie ein Terminal und klonen Sie das Repository:

git clone https://github.com/Mintplex-Labs/anything-llm.git - Wechseln Sie in das Verzeichnis:

cd anything-llm - Installieren Sie die Abhängigkeiten:

pip install -r requirements.txt - Starten Sie die Anwendung:

python main.py

Schritt 2: DeepSeek lokal einrichten

- Laden Sie das DeepSeek-LLM-Modell herunter (z. B.

deepseek-llm-7boderdeepseek-llm-67b). Sie finden die Modelle auf OLLAMA. - Installieren Sie

ollama, falls nicht bereits vorhanden:curl -fsSL https://ollama.com/install.sh | sh - Laden Sie das DeepSeek-Modell für Ollama:

ollama pull deepseek/deepseek-llm-7b - Testen Sie das Modell lokal:

ollama run deepseek/deepseek-llm-7b

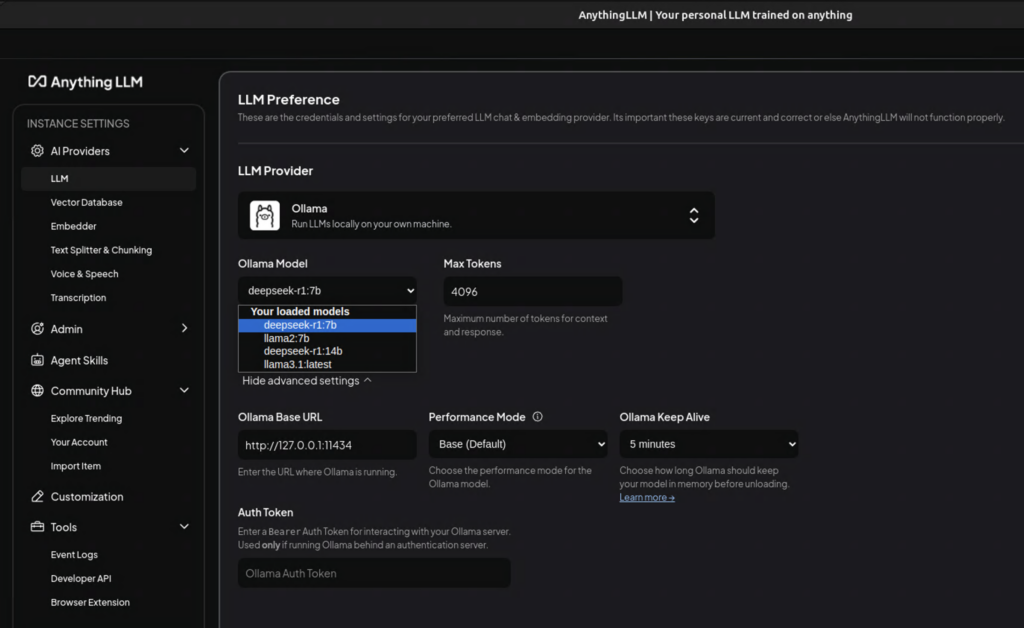

Schritt 3: DeepSeek in AnythingLLM einbinden

- Öffnen Sie die Konfigurationsdatei von AnythingLLM (

config.json). - Ändern Sie die LLM-Einstellungen, sodass Ollama als Provider verwendet wird:

{ "llm_provider": "ollama", "ollama_model": "deepseek/deepseek-llm-7b" } - Speichern Sie die Datei und starten Sie AnythingLLM neu:

python main.py - Greifen Sie über die Web-Oberfläche auf AnythingLLM zu und nutzen Sie DeepSeek lokal für Ihre Anfragen.

Fazit

Mit dieser Einrichtung können Sie AnythingLLM vollständig lokal nutzen, ohne Ihre Daten an externe Server zu senden. DeepSeek läuft direkt auf Ihrem Rechner, was Datenschutz und Geschwindigkeit verbessert. Probieren Sie es aus und erleben Sie die Vorteile eines leistungsstarken lokalen KI-Assistenten!